Gdy w latach 80. XX wieku przenosiłam się z Uniwersytetu Jagiellońskiego na uczelnię w Leicester, zauważalna była różnica w liczbie studentek i studentów. W socjalistycznej Polsce na jednym roku informatyki było nas tyle samo, ilu mężczyzn. Na wydziale w Wielkiej Brytanii kobiety stanowiły raptem 15 procent – wspomina prof. Marta Kwiatkowska z Wydziału Nauk Informatycznych Uniwersytetu Oxfordzkiego.

TYGODNIK.TVP.PL: Najstarsze, najbardziej prestiżowe towarzystwo naukowe i jedyna zasiadająca w nim Polka. Na dodatek jedna z niewielu kobiet…

PROF. MARTA KWIATKOWSKA: W Royal Society jest jeszcze jeden Polak, prof. Artur Ekert. Tak się to złożyło, że to także naukowiec, który studiował na UJ. Zajmujący się fizyką kwantową i kryptografią, również pracownik Oxfordu. Odnośnie liczby kobiet, to długa historia. Jesteśmy przyjmowane do klubu dopiero od roku 1945 i faktycznie kobiety nadal są w widocznej mniejszości.

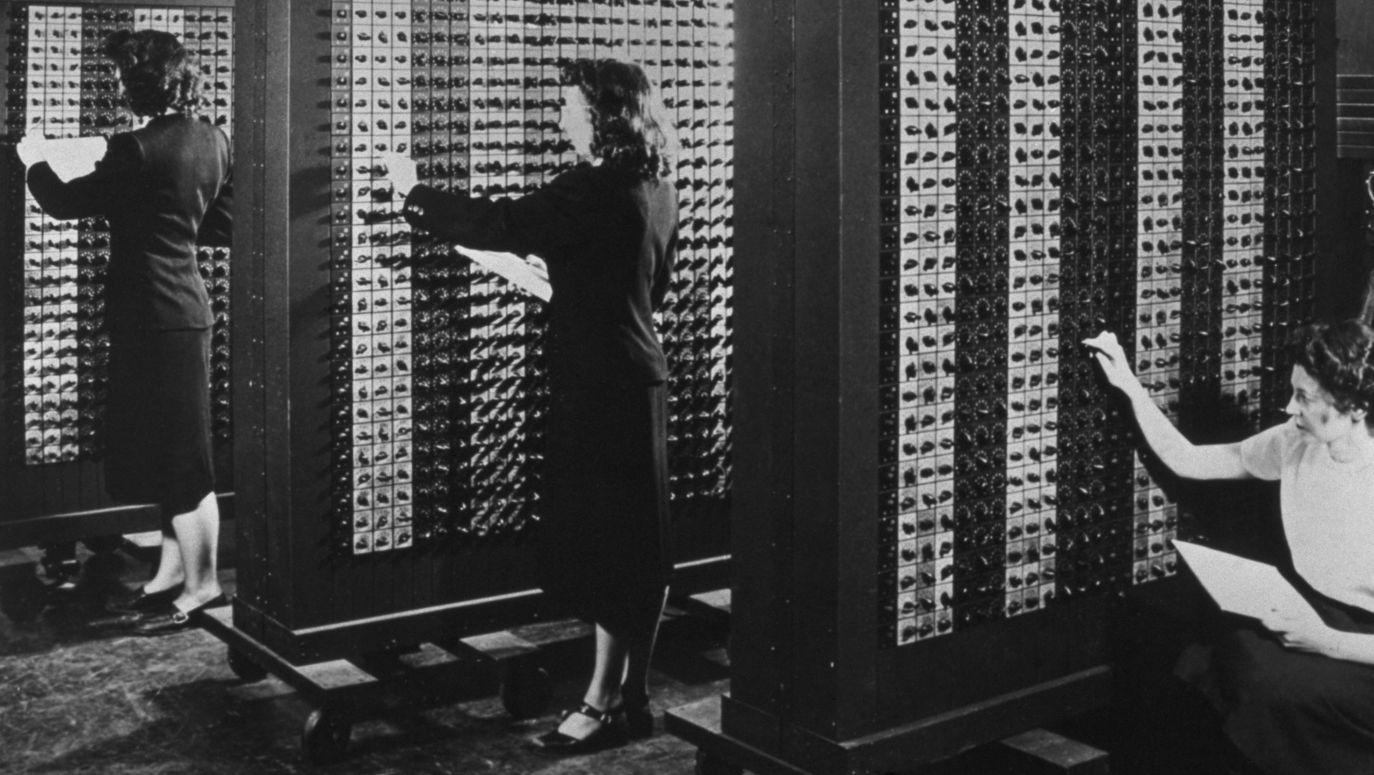

Skoro mówimy o informatyce, to wynalazek sztucznej inteligencji byłby niemożliwy bez kobiet. To asystentki kryptologa i ojca informatyki Alana Turinga wykonywały skomplikowane obliczenia na kartach, stając się prekursorkami współczesnych procesorów.

Sięgnijmy dalej (śmiech), przecież to brytyjska matematyczka Ada Lovelace współpracowała z Charles’em Babbage’m przy konstrukcji tzw. maszyny analitycznej, pierwszego mechanicznego komputera. Logika działania tej maszyny, której nie skończono, była bardzo podobna do zasad tymczasowego komputera cyfrowego. Sama wynalazczyni zmarła dość młodo w 1852 roku, w wieku 36 lat, ale już w połowie XIX wieku zdążyła pracować nad czymś, co dziś nazwalibyśmy… programowaniem.

150 lat po wspomnianej pani Lovelace udział kobiet wśród naukowców zajmujących się najnowszymi technologiami jest nadal niski. Z czego to wynika?

Mamy wielki technologiczny boom nazywany czwartą rewolucją przemysłową, ale kobiety mają w nim bardzo mały udział. Dlaczego tak jest, nie wiem… To zespół skomplikowanych czynników. Gdy w latach 80. XX wieku przenosiłam się z Uniwersytetu Jagiellońskiego na uczelnię w Leicester, to także było zauważalne. W socjalistycznej Polsce na jednym roku informatyki było nas tyle samo, ilu mężczyzn. Na wydziale w Wielkiej Brytanii kobiety stanowiły raptem 15 procent. Do dziś ten trend jest widoczny. Może chodzi o jakieś wzorce kulturowe lub wybory życiowe samych dziewcząt.

Ada Lovelace (portret z ok. 1835 roku) urodziła się w 1815 roku jako jedyne ślubne dziecko poety lorda Byrona. Uznawana jest za pierwszą na świecie programistkę. Fot. New York Public Library/Interim Archives/Getty Images

A czy jest pani za parytetem?

Zdecydowanie nie! Jestem za merytokracją. O ile wiem w Europie nie mamy żadnych akcji afirmacyjnych na modłę amerykańską, gdy grupy dyskryminowane mają zagwarantowane miejsce na uczelniach i uważam ten stan rzeczy za właściwy. Dużą rolę odgrywać powinny nie tylko szkoły i uniwersytety, ale również media. To państwo, dziennikarze powinniście zachęcać młode dziewczęta do nauki matematyki już od najmłodszych lat, tworzyć równie szanse.

Będziemy się starać! Skoro wspomina pani rewolucję techniczną, to można pozazdrościć, iż obserwowała pani rozwój informatyki praktycznie od jej własnej „epoki kamienia łupanego”.

Gdy wyjeżdżałam z Polski 35 lat temu, komputery zajmowały kilka pokoi. Korzystaliśmy też z komputerów „mini” – był wielkości biurka z ekranem kineskopowym na górze, ale rozdzielczość tego ekranu była śmiesznie mała, raptem 40 znaków. Gdy zaczęłam doktorat w Anglii, dostałam swojego pierwszego Macintosha. Dziś na naszym stoliku leżą dwa smartfony, urządzenia o mocy obliczeniowej kilka tysięcy większej od tamtejszych komputerów.

Nasi naukowcy mają to „coś”. Stwórzmy polską Dolinę Krzemową

Polscy naukowcy mogą się wykazać dopiero, gdy wyjadą z Polski – mówi prof. Wiesław Nowiński.

Jak wtedy programowano?

Byłam jednym z pierwszych roczników informatyki i pierwszym, któremu pozwolono programować na amerykańskim komputerze CDC Cyber. Oczywiście wcale nie oznaczało to „programowania” w dzisiejszym tego słowa znaczeniu, zapisywaliśmy kod na kartach perforowanych, przekazywaliśmy je przez okienko paniom (śmiech). Zresztą nawet na owe amerykańskie komputery obowiązywało naukowe embargo, więc miały zmniejszona konfiguracje.

Jak to się stało, że z siermiężnego PRL trafiła pani do świata zachodniego?

Po skończeniu studiów zaczęłam pracować na UJ jako asystentka i chciałam zrobić doktorat. Planowałam studia doktoranckie w Warszawie, ale niestety musiałam je przerwać z powodów finansowych. Więc w 1984 roku pojechałam na doktorat do Anglii, gdzie dostałam stypendium, a niedługo później przeszłam na posadę stałą wykładowcy informatyki w Leicester. Po przeniesieniu się do Birmingham, awansowałam na docenta i profesora. Od 2007 jestem profesorem w Oksfordzie jako pierwsza kobieta na takiej posadzie w dziedzinie informatyki. Z jednej strony, emigracja do Anglii była stosunkowo prosta, bo przeniosłam się na podobna posadę i znałam język, ale z drugiej strony musiałam się dostosować do międzynarodowego poziomu w mojej dziedzinie, w czym pomógł mi wysoki standard nauczania informatyki na UJ.

Wtedy kartki z liczbami, dziś skomplikowane algorytmy. W jakim kierunku zmierza rozwój informatyki?

„Zmierza” to ważne słowo. Ten rozwój wcale się nie zatrzymuje, choć nam często się wydaje, że osiągnęliśmy sufit. Komputery kwantowe będą kolejną wielką rewolucją w informatyce, pozwolą na realizowanie obliczeń na znacznie większą, niewyobrażalną dla nas dziś skalę. Będą z pewnością stosowane do skomplikowanych obliczeń związanych z szyfrowaniem i systemem bankowym.

ENIAC uważany za pierwszy elektroniczny komputer cyfrowy, skonstruowany w latach 1943–1945. Fot. CORBIS/Corbis via Getty Images

Myśląc „komputer”, posługujemy się pewnym stereotypem.

Zdecydowanie tak. Wielkość komputerów znacznie się zmieniła, ale procesory PC, tabletów czy smartfonów mają de facto taki sam design wewnętrzny jak urządzenia z lat 40. ubiegłego wieku. Zaszła drastyczna miniaturyzacja, ale zasada budowy mikroprocesora jest taka sama. Jego funkcja także: po prostu wykonuje równolegle określoną liczbę obliczeń, ostatnio komunikuje się także z innymi procesorami czy czujnikami, które nosimy.

Pani tymczasem w jednym z ostatnich artykułów sugeruje, że czas na inne sposoby zapisu danych.

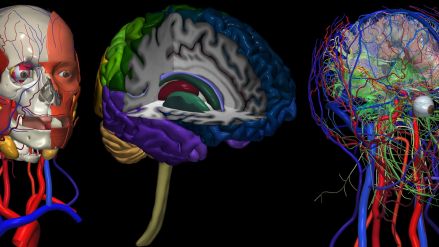

Okazuje się, że najbardziej efektywnym nośnikiem danych cyfrowych są sieci DNA. I nie chodzi tylko o pozyskiwanie informacji z istniejących komórek ciała pana czy mojego, ale o wykorzystanie sztucznie wytworzonych sieci do zapisu bardzo dużej ilości informacji. Do tego takie nici kwasu dezoksyrybonukleinowego są znacznie tańsze do wyprodukowania i potrzebują znacznie mniej energii do wykonywania obliczeń. Już udało się zdigitalizować w ten sposób dzieła sztuki i filmy. Być może w przyszłości będą tak zapisywane inne dobra kultury, potężne biblioteki danych lub archiwa.

Fragment mojego ucha lub palca będzie dyskiem zewnętrznym?

Niewykluczone. Pamięć zapisana na DNA wymaga wielokrotnie mniejszej powierzchni, jest znacznie wydajniejsza od wielkopowierzchniowych serwerowni, które wymagają dużo energii zarówno do funkcjonowania, jak i chłodzenia układów. Nie oznacza to, że są bardziej konkurencyjne od tradycyjnej pamięci. Sztuczne DNA wymaga odpowiedniej temperatury i wykonuje operacje wolniej od krzemowych mikroprocesorów. Badania są tu na bardzo wstępnym etapie. Dopiero naukowcy tacy jak dr. Karin Strauss wykażą, czy zapis na materii organicznej jest przyszłością informatyki.

Nadchodzi era człowieka 2.0. Nowe zmysły, protezy wzroku, implanty pamięci i elektroniczne organy

Już dziś mogę „wskrzesić” Marilyn Monroe czy inną zmarłą osobę – mówi Piotr Psyllos, jeden 30 najlepszych europejskich innowatorów poniżej 30. roku życia.

Granica pomiędzy pani nauką a biologią się zaciera…

Przede wszystkim zaciera się granica informatyki i medycyny. Przyszłością jest komunikowanie się organizmów żywych z komputerami. Zresztą to dzieje się tu i teraz, powstają biosensory wykrywające złe molekuły powodujące choroby lub wszczepiane interfejsy komputerowe mózgu. Fakt, że ludzie sportowo aktywni używają akcesoriów fit bit to dopiero początek. Współpracuję z biofizykiem, który chce stworzyć nowy sposób dystrybucji leków w ciele człowieka. Obecnie leczenie raka odbywa się bardzo inwazyjnymi metodami, często niszcząc tkankę człowieka. Być może kiedyś lekarstwo będzie krążyć po naszym organizmie, identyfikować i naprawiać chore tkanki.

Komunikowanie maszyny i człowieka to ważny aspekt pani badań, szczególnie dotyczących samochodów bez kierowców.

Ostatnio mieliśmy kilka wypadków, w tym śmiertelnych, związanych z niewłaściwą reakcją maszyn na zachowanie człowieka. System LIDAR zidentyfikował poruszający się obiekt, ale system kierujący pojazdem podjął niewłaściwą decyzję. Zawiodło uczenie maszynowe. System był nauczony tego, że ktoś może przechodzić przez ulicę, ale nie że będzie prowadził rower! Nie wziął pod uwagę czegoś tak prozaicznego jak rowerzysta będący chwilowo pieszym w niedozwolonym miejscu.

Sztuczna inteligencja okazała się głupia.

Sztuczna inteligencja jest jeszcze bardzo głupia. Trudno to nazwać inteligencją, to bardziej idea wykreowana przez media. Ta rzekoma inteligencja w niczym nie dorównuje człowiekowi. Potrafi jedynie klasyfikować wprowadzone przez człowieka informacje i podejmować na ich podstawie decyzje. Nie daje sobie rady z kontekstem, w którym działa system.

Złe decyzje kursanta prawa jazdy skutkują oblaniem egzaminu. Systemy, które piszemy pełnią podobną funkcję w stosunku do komputerów pokładowych samochodów autonomicznych. Wypracowuję systemy oprogramowania, które sprawdzają, czy uczenie maszynowe popełnia błędy. Udowadniam, czy sztuczna inteligencja stosowana w pojazdach autonomicznych działa poprawnie lub niepoprawnie i opracowuję rozwiązania, które pozwalają zweryfikować, czy algorytmy kierujące samochodem będą podejmować właściwe decyzje na drodze.

Autonomiczne samochody faktycznie będą największym trendem technologicznym naszego wieku?

Na razie ich wprowadzanie na drogi użytkowane przez innych kierowców jest olbrzymim problemem. Samochody Tesli ze swoimi systemami absolutnie nie radzą sobie w ruchu na małych ciasnych uliczkach, potrafią jedynie funkcjonować jako bardziej zaawansowany tempomat na autostradach. Do tego dochodzą zupełnie nieprzewidywalne zachowania ludzi czy zwykła złośliwość. Człowiek wie, że auto autonomiczne ustąpi mu miejsca, więc wymusza pierwszeństwo. Zarządzający transportem publicznym w Las Vegas mieli problem, z tym, iż ludzie dla zabawy wymuszali zatrzymanie na autobusiku bez kierowcy.

Autonomiczny E-Golf testowany przez Volkswagena na ulicach Hamburga. Fot. REUTERS/Fabian Bimmer

Mimo wszystko auta autonomiczne mogą zmniejszyć liczbę wypadków.

Na razie są zbyt ostrożne, co irytuje innych użytkowników drogi. Na przykład zbyt wolno wjeżdżają na rondo. Okazuje się, że podejmowanie decyzji przez system pokładowy trwa dłużej niż u człowieka. Dodatkowo systemy nauczania samochodów autonomicznych muszą mieć bardzo dużą wyobraźnię, przewidywać wszystkie możliwe zachowania, fakt, że na ulice może wbiec dziecko, na poboczu może poruszać się kobieta z wózkiem, na drogę może wtargnąć zwierzę.

Albo sam znak drogowy został zamazany.

To faktycznie jest poważny problem. Człowiek jest w stanie rozpoznać zniszczony znak lub wnioskować, czy był nakazem, czy zakazem. Tego rodzaju problemy może zmienić upowszechnienie sieci 5G. Być może znaki wcale nie będą potrzebne, gdyż auta będą komunikować się ze sobą, a sensory drogowe będą pełnić funkcję znaków.

Nie będziemy obawiać się pijanych kierowców, ale ataku hakerów?

Na tego rodzaju zagrożenia będziemy musieli bardzo uważać. We współczesnym świecie brakuje rzetelnej debaty na temat tego, czym jest sztuczna inteligencja, jakie rodzi dla społeczeństwa szanse i jakie zagrożenia. Według mnie ostatnio większym zagrożeniem od hakerów są np. drony, których rozwój nastąpił bardzo szybko i wymaga nowych regulacji.

Dystopijna wizja świata, w której rządzą maszyny to daleka przyszłość?

Interesuje mnie także miejsce robotów we współczesnym społeczeństwie. Wielkim wyzwaniem badawczym jest takie zaprojektowanie i zaprogramowanie robota, aby budził większe zaufanie.

Auta elektryczne będą jak hulajnogi

Dzisiejsze dzieci, gdy dorosną nie będą chciały mieć na własność samochodu spalinowego. Będą wypożyczać auta elektryczne – przewiduje Anna Skarbek-Żabkin, ekspert motoryzacyjny.

Zaufanie człowieka do robota czy robota do człowieka?

Oba aspekty są istotne! Roboty też muszą nauczyć się komunikować z człowiekiem i w jakimś sensie darzyć go zaufaniem, rozumieć i wykonywać polecenia. Weźmy pierwszy z brzegu przykład. Nowoczesne zespoły strażackie ratujące ludzi z pożarów coraz częściej wykorzystują roboty, które są w stanie wejść do palącego się domu i ratować ludzi. Współpracują razem jako zespół. Tyle że taki robot musi umieć rozpoznawać takie ludzkie emocje jak stres czy strach ofiary, którą ratuje. Wyzwaniem jest konstruowanie maszyn obdarzonych empatią. Ale to się już dzieje, w szpitalach maszyny zaczynają opiekować się ludźmi.

Skoro mamy funkcjonować obok siebie, to kto będzie władcą, a kto sługą?

To oczywiste! Jestem przekonana, że to człowiek powinien pełnić władzę nad robotem, i potrzeba do tych nowych sytuacji odpowiedniej regulacji prawnej, ubezpieczenia, np. kto będzie odpowiedzialny, gdy opiekuńczy robot zrani dziecko? Poza tym wszystko jest kwestią tego, jak my, naukowcy będziemy projektowali te urządzenia, czy one są godne zaufania i mogą z ludźmi efektywnie współpracować.

– rozmawiał Cezary Korycki

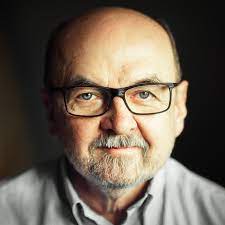

Fot. University of Oxford

W tym miesiącu : 584

W tym miesiącu : 584 Ogółem : 352619

Ogółem : 352619 Ilu jest Online : 0

Ilu jest Online : 0 Twój adres IP : 216.73.216.80

Twój adres IP : 216.73.216.80